题 目:Self-Training with Pseudo-Label Scorer for Aspect Sentiment Quad Prediction

会 议:ACL 2024

作 者:张义策,曾杰#,胡伟明#,王梓屹#,陈诗炜,徐睿峰*

单 位:哈尔滨工业大学(深圳)

代码链接:https://github.com/HITSZ-HLT/ST-w-Scorer-ABSA

一、引言

方面情感四元组预测(Aspect Sentiment Quad Prediction, ASQP)是方面级情感分析中最具代表性和挑战性的任务,其目的是预测评论中的所有四元组(方面项、方面类别、观点项、情感极性)。比如,给定评论“the food is great and reasonably priced”,ASQP任务的输出是{(food, food quality, great, positive), (food, food prices, reasonably priced, positive)}。

ASQP任务的关键挑战是标记数据的不足,这限制了现有模型的性能。许多研究者使用数据增强方法来缓解这个问题。然而,数据增强方法的一个显著问题是会不可避免地引入文本和标签不一致的样本,这反而会损害模型的学习。为了减少不一致的样本,本文为数据增强方法引入了一个伪标签打分器。如图1所示,该打分器旨在评估文本和伪标签之间的一致性。如果我们有一个足够健壮的打分器,我们就可以将所有不一致的样本过滤掉,因而极大地提高数据增强的有效性。我们提出打分器的有效性和可靠性取决于两个关键因素:(1) 训练数据的质量和 (2) 打分器的架构。接下来,我们分别讨论这两个因素。

图1:伪标签打分器的示意图

为了训练打分器,我们需要带正标签和负标签的数据。前人的工作一般通过启发式的规则来构建负标签。然而,这些负标签通常简单且模式化的,这会限制打分器的学习。因此,我们构建了一个人类标注的比较数据集。具体来说,我们首先使用现有的标记数据训练一个ASQP模型,然后使用该模型为无标注数据生成多个伪标签,接下来让标注者从中选择最适合的伪标签作为正标签,并将其他标签作为负标签。我们的数据集和基于规则的数据相比,更具挑战性而且更好地与人类的判断对齐。此外,我们还探索了使用大语言模型代替人类标注者的可能性。

对于第二个因素(打分器的架构),前人的工作将对标签的打分视作一个问答问题或者将匹配标记嵌入到标签中。然而,我们发现这些方法对文本和伪标签匹配程度的建模能力较弱,在ASQP这样的复杂任务上表现不佳。受到最近偏好优化工作的启发,我们将生成模型为伪标签赋予的条件似然作为对其质量的打分。和前人的方法相比,该方法可以逐token地检查伪标签的合理性,因而提供一个更加全面且有效的打分。

二、比较数据集的构建

2.1 数据准备

我们从Yelp数据集和Amazon Laptop数据集中收集了大量的无标记评论。我们将这些评论切分为句子。接下来,我们使用现有的标记数据集训练一个ASQP模型,然后利用该模型通过beam search来为每个句子生成四个伪标签。

2.2 标注过程

对于一个句子和它的四个伪标签,标注者有六个选项。前四个选项对应四个伪标签,第五个选项表明四个标签都不适合,第六个选项表明句子没有表达任何情感或者表达的情感不够清晰。当选择了第五个选项,标注者需要写一个替代的标签。标注过程分为多个批次进行,每个批次大约包含200条样本。为了确保准确性,每条样本由三名不同的标注者独立标注。如果标注结果出现分歧,第四名标注者会介入以解决不一致的情况。此外,在每个批次结束时,四名标注者会讨论并解决任何分歧。每个标注者都被提供了标注指南和现有的已标注的ASQP数据集。

AI标注:选择最合适的标签虽然比从头开始标注ASQP标签要简单得多,但仍然是一项繁重的任务。因此,我们探索了使用ChatGPT代替人工标注的可行性。为了确保AI标注的质量,我们为每个ASQP数据集精心设计了提示。此外,我们采用了三种策略来增强标注过程:自一致性、自评估和解释增强。

2.3 统计信息

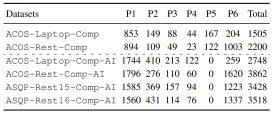

我们构建了两个人工标注和四个AI标注的比较数据集。它们的基本统计信息如表1所示。训练打分器时,我们去掉选项6对应的样本,并保留一部分数据作为开发集用于超参数调优和模型选择。具体来说,对于餐馆数据集,我们预留了200个样本,对于笔记本电脑数据集,我们预留了300个样本。如此,人工标注数据集中的训练样本约为1000条,AI标注数据集中的训练样本约为2000条。

表1:比较数据集的统计信息。P1-P6对应选择选项1-6的样本数量。

三、我们的方法

3.1 伪标签打分器

伪标签打分器的目标是对评论和伪标签之间的匹配进行评分。之前的研究将这一评分任务形式化为问答问题,或者将匹配标记嵌入到标签中。然而,这些方法难以有效捕捉评论和伪标签之间的交互。受最近偏好优化工作的启发,我们采用生成模型作为评分器。给定评论句子![]() 和伪标签

和伪标签![]() ,它们的匹配分数正比于生成模型赋予的条件概率:

,它们的匹配分数正比于生成模型赋予的条件概率:

![]()

与之前的方法相比,该方法通过结合伪标签中每个标记的似然来得出其总体得分,从而提供了全面且有效的评分。在此基础上,我们在比较数据集上使用排序的目标来优化伪标签打分器。

训练. 我们在比较数据集上使用基于排序的损失函数优化伪标签打分器。我们探索了多种排序方法,最终使用列表级方法来计算损失:

其中,![]() 表示正标签,

表示正标签,![]() 表示负标签。

表示负标签。

3.2 带数据过滤的自训练方法

自训练是一种简单且经典的半监督技术,可以用于数据增强。它包含三个主要步骤:(1)用现有标注数据集训练初始模型,(2)使用该模型为未标注数据生成伪标签,(3)将这些伪标签数据并入标注数据集。然而,自训练方法会不可避免地会引入低质量的伪标签,即标签与给定评论不准确匹配。为了克服这个问题,我们设计了一个两阶段过滤过程。

(1) 基于置信度的过滤。首先,我们将初始模型对伪标签的置信度作为其质量的衡量指标。如此,我们过滤掉那些置信度低于阈值![]() 的样本。

的样本。

(2) 基于打分器的过滤。接下来,我们使用伪标签打分器对剩余样本进行评估。我们观察到,得分低的伪标签质量往往较差。此外,虽然高分样本通常显示出良好的标签质量,但其句子往往过于简单,对后续模型训练的帮助有限。因此,我们仅保留那些得分在阈值 ![]() 和

和 ![]() 之间的样本。

之间的样本。

3.3 将伪标签打分器作为重排序器

重排序最初是信息检索中的一个概念,指的是对初步候选结果进行重新评分和排序的过程。最近的工作表明,在信息提取任务中引入一个重排序步骤可以提升性能。在本文中,我们认为我们的伪标签打分器可以作为这样的重排序器。具体来说,对于一个给定的评论,我们首先使用ASQP模型通过beam search生成四个候选标签,然后使用我们的伪标签打分器从这些候选标签中选出最优的一个作为最终的输出。

四、实验结果

4.1 对伪标签打分器的分析

考虑到伪标签打分器在我们框架中的重要性,我们首先对其进行分析,重点关注两个关键方面:其模型架构和训练数据集。

模型架构。我们使用生成模型赋予伪标签的条件似然作为评分标准。为了检验我们方法的有效性,我们在两个人工标注的比较数据集上进行实验,并将我们的方法与之前的方法进行对比。正如表2所示,之前的方法,尤其是问答方法,在ASQP任务中表现较差。相比之下,我们的方法具有显著的优势,证明了其有效性。

表2:伪标签打分器在架构上的实验结果。

比较数据集。我们进行实验以比较不同的标注方案,结果列在表3中。我们可以得到以下结论:(1)利用人工或AI来标注比较数据是非常重要的,因为它们的表现明显优于未标注的数据。特别地,当没有合适选项时允许人工标注人员撰写标签可以显著提高性能。(2)将打分器与比较数据和原始ASQP数据集结合进行训练,比仅使用比较数据更有效。(3)AI标注的比较数据甚至可以获得比人工标注的比较数据更好的结果。

表3:不同标注方案的性能(准确率,%):(1)NONE表示不进行标注的方法,选择模型信度最高的伪标签作为正标签;(2)HUMANN-1234表示人工标注人员从四个伪标签中选择最佳标签的标注方案;(3)HUMANN-12345在HUMANN-1234的基础上扩展,允许人工标注人员在四个选项都不合适时撰写额外标签;(4)AIANN-1234与HUMANN-1234类似,但由ChatGPT替代人类标注者;(5)带有*的方法表示使用比较数据集和原始ASQP数据集共同训练打分器的方法。

我们进一步分析了AI标注。表4展示了AI标注数据与人工标注数据之间的一致性。尽管一致性在统计上并不高,但考虑到此任务的主观性,AI标注的质量是可以接受的。此外,AI标注的一个显著优势在于其相对于人工标注的成本效益,使得能够高效获取大量标注数据。图2展示了人类标注数据和AI标注数据相对于其数量的性能趋势。尽管AI标注数据在相同数量时表现较低,但AI标注的可扩展性使其在使用更多数据时能够追上并可能超过人工标注数据的性能。例如,超过2000个AI标注样本可以等同或超越1000个人工标注样本。因此,我们可以得出结论,对于ASQP任务,用AI替代人工来标注比较数据是可行的。

表4:AI标注数据与人工标注数据之间的一致性(%)。P6指的是选择了选项6的样本。我们在移除这些样本之前和之后分别计算一致性。

图2:随着对比数据量增加的性能趋势(准确率,%):(a) ACOS-Laptop上的结果;(b) ACOS-Rest上的结果。

4.2 对自训练的分析

主要结果。在伪标签打分器的基础上,我们设计了一个自训练框架,实验结果如表5所示。可以看到我们的方法显著且持续地提高了现有ASQP方法的性能。具体来说,GAS在四个数据集上的F1-score分别提升了2.94%、4.32%、5.17%和5.96%,平均提升4.60%;MUL在这些数据集上的F1-score分别提升了3.72%、3.39%、2.98%和4.36%,平均提升3.61%。在结合我们的方法后,GAS和MUL都超越了之前的方法。这些结果证明了我们方法的有效性。

此外,我们还有以下观察:(1)两阶段过滤过程,即CS-FILTER,大大提高了自训练的有效性。在大多数数据集中,相较于单独自训练,这种方法提升了超过2%,这突显了数据过滤在自训练框架中的重要性。(2)加入重排序步骤可以进一步提高约1%的性能。(3)在下游自训练中使用AI标注的数据可以达到与使用人工标注数据相当的效果。这进一步表明,用AI替代人工进行比较数据标注是可行的。(4)ChatGPT在ASQP任务中的表现较差,这表明直接用于此任务并未充分利用其能力。相反,用它进行比较数据标注有效地发挥了其优势。(5)值得注意的是,我们的过滤策略在ACOS-Laptop上的提升相对有限。我们认为这是由于其ASQP标注与我们的比较标注之间存在的不一致性。更详细的讨论参见论文的further analysis部分。

表5:四个ASQP数据集上的实验结果(%)。C-FILTER表示应用基于信度的过滤。CS-FILTER表示结合了基于信度和基于打分器的过滤。

匹配分数的影响。我们的方法依赖于伪标签打分器输出的匹配分数来进行数据过滤。我们进行了实验以检验这些分数对自训练性能的影响。图3表明,随着匹配分数的增加,性能逐步提升。然而,超过某一阈值后,进一步增加匹配分数会导致性能下降。这一现象验证了我们的假设,即分数过低的样本标签质量较差,会对模型学习产生负面影响,而分数过高的样本往往过于简单,对后续模型训练帮助有限。

图3:在不同的匹配分数下,GAS在增强数据集上的性能(F1-score,%)。

数据量的影响。伪标注样本的数量是影响自训练有效性的另一个重要因素。我们进行了实验来分析其影响。正如图4所示,随着数据量的增加,性能总体上呈上升趋势。特别是经过两阶段过滤后,这一趋势更加稳定和明显,强调了数据过滤的必要性。此外,我们注意到,当增强样本数量超过20000时,自训练性能有所下降。这表明仅通过增加数据量来提升性能是有一定限度的。平衡多样性和标签质量以增强自训练的有效性值得在后续研究中进一步探索。

图4:在不同增强样本数量下,GAS的性能(F1-score,%)。

五、总结

在本文中,我们引入了一个用于方面情感四元预测(ASQP)任务的伪标签打分器,以减少数据增强中的不匹配。我们提出这个打分器的有效性和可靠性依赖于两个关键方面:训练数据集的质量及其模型架构。为此,我们构建了人工和AI标注的比较数据集,并提出了基于生成式模型的评分方法。在得到这个打分器后,我们将其应用于自训练框架中的数据过滤,并进一步将其作为重排序器来增强ASQP模型。详细的实验和分析展示了我们比较数据集和所提出的架构的有效性。此外,在四个公开的ASQP数据集上的实验结果表明,我们的打分器显著且持续地提升了现有方法的性能。